Las tres leyes de la robótica son un conjunto de reglas descritas por el escritor estadounidense de ciencia ficción Isaac Asimov en su relato de 1942 "Círculo vicioso" (Runaround) -recogido en la recopilación de relatos de 1950 "Yo, Robot"- y presentes en gran parte de su obra, dirigidas a delimitar el comportamiento básico de los robots en sus interacciones con los humanos y con otros robots.

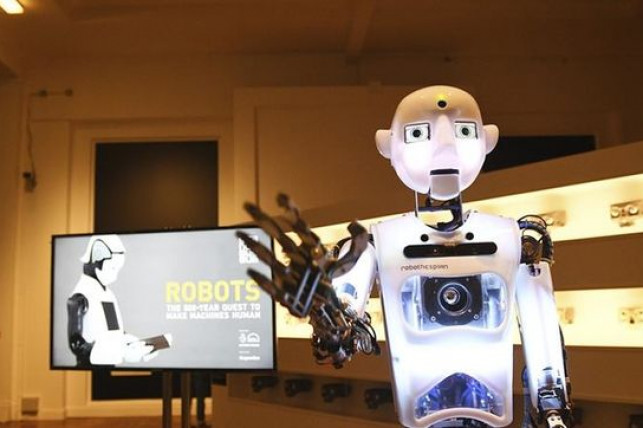

La robótica constituyó uno de los temas favoritos de Isaac Asimov y se ve reflejado en gran parte de su prolífica obra. A lo largo de la misma, en reiterados relatos se hace alusión a las "Tres Leyes de la Robótica".

Estas son las siguientes:

Un robot no hará daño a un ser humano o, por inacción, permitir que un ser humano sufra daño. Como podréis observar, es una protección básica del ser humano. El robot deberá anteponer la integridad (física o psicológica) de la persona a cualquier otra cosa

Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la primera ley. La Segunda Ley de la Robótica tampoco deja lugar a la duda; el robot deberá obedecer SIEMPRE al ser humano (lo que le deja en una posición total de dependencia de las personas) salvo si la orden que recibe es la de hacer o permitir daño a un humano

Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la primera o la segunda ley. Finalmente, la Tercera Ley de la Robótica supone la rendición absoluta de los robots a los humanos. Los robots tienen el deber de protegerse, pero deben ser sumisos a los humanos, hasta el punto estar obligados de obedecer si reciben la orden de autodestruirse

Las tres leyes que figuran en la obra de Asimov suponen la rendición total de los robots a los humanos, la completa asunción de su papel como esclavos.

Posteriormente, en 1985, Asimov introdujo en su libro Robots e Imperio, una cuarta norma, denominada como Ley Cero de la Robótica, con el siguiente enunciado: "Un robot no puede causar daño a la humanidad o, por inacción, permitir que la humanidad sufra daño".

Las tres leyes que figuran en la obra de Asimov suponen la rendición total de los robots a los humanos, la completa asunción de su papel como esclavos

Por el propio contenido de esta Ley, las tres anteriores quedarían subordinadas a la misma. No obstante, y como se vería en la posterior obra de Asimov, la aplicación de la Ley Cero supondría enormes problemas, por la dificultad para determinar qué es la Humanidad y lo que se considera más favorable para ella.

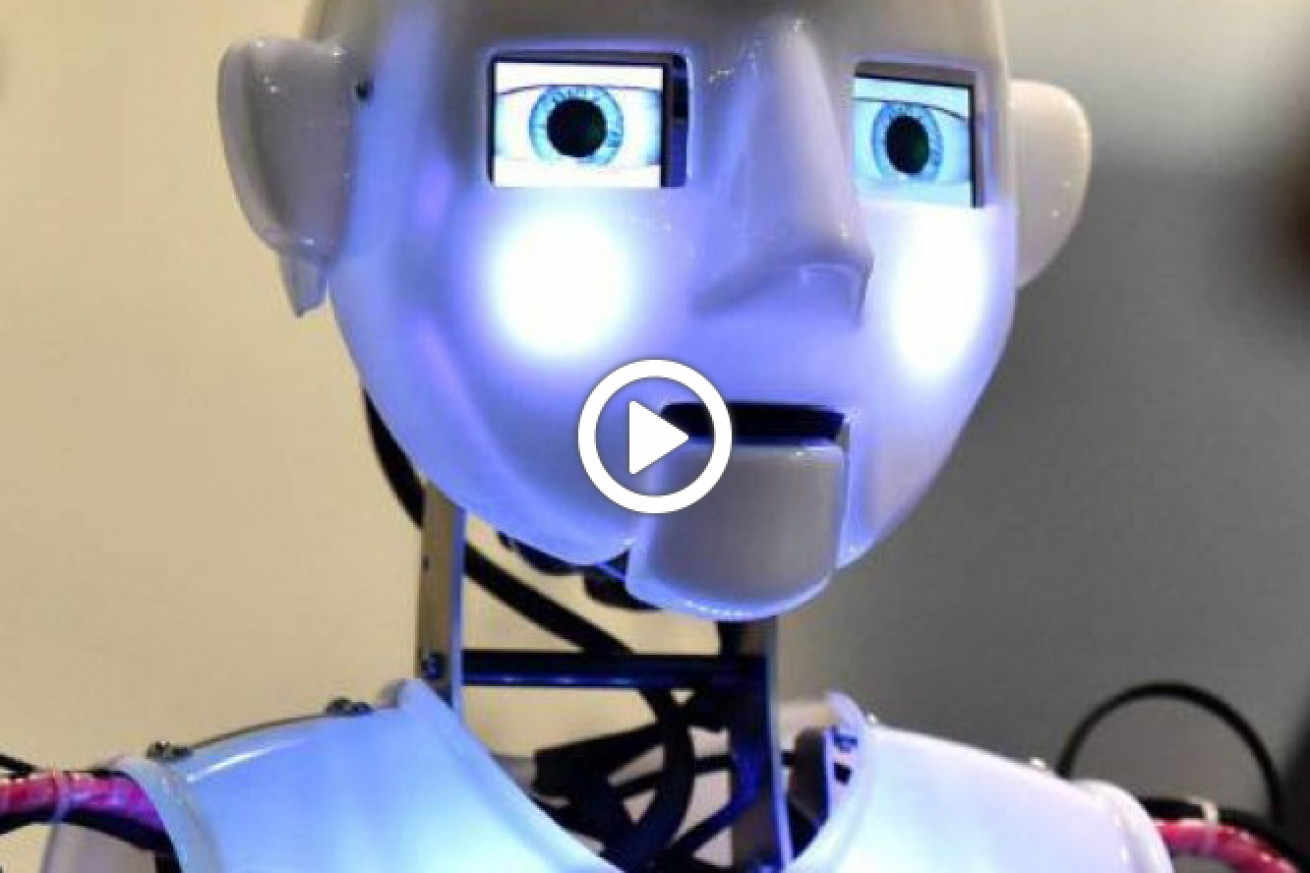

Tradicionalmente, por su precisión y su carácter pionero, se ha considerado las tres leyes de la robótica de Asimov como la referencia a la hora de determinar el comportamiento básico que debería tener un robot. Pero, en el futuro y cuando los robots muestren una inteligencia similar a la de un ser humano adulto, ¿Será posible delimitar sus acciones con un conjunto de reglas tan precisas?

A lo largo de la obra de Asimov se plantean interesantísimas cuestiones relativas a la forma en que los robots aplicarían las tres leyes; por ejemplo, ¿Cómo actuarían en el caso de tener que decidir entre la vida de varios humanos? ¿Cómo determinarían lo que es "daño" o los diferentes niveles de “daño” que un ser humano puede recibir? ¿Son más graves los daños psicológicos o los físicos?

Las leyes de la robótica propuestas por Asimov son imaginativas y prácticas dentro del universo que el fantástico escritor recrea. Sin embargo, tienen una carencia: por más visionario que fuera Asimov (¡Y vaya si lo era!) son hijas del conocimiento científico y tecnológico de su época. Y desde entonces, las cosas han cambiado, y mucho.

¿Y más allá de la obra de Asimov? ¿Existe algún criterio actualizado sobre cómo deberían ser las reglas de comportamiento de los robots? No aún, o no al menos de manera formal. En 2011, el Consejo de Investigación de Ingeniería y Ciencias Físicas (EPSRC) y el Consejo de Investigación de Artes y Humanidades (AHRC) del Reino Unido publicaron un "conjunto de cinco principios éticos para los diseñadores, constructores y los usuarios de los robots en el mundo real", pero se trata de un grupo de reglas más bien destinadas a los diseñadores de robots, y no tanto a los robots mismos.

Llegados a este punto, volvamos a la cuestión original. Cuando los robots estén desarrollados hasta alcanzar la inteligencia de un ser humano adulto, Será posible delimitar su comportamiento conforme a un conjunto de reglas? Para dar respuesta a esta pregunta deberíamos observar la mejor referencia que tenemos: el propio ser humano.

El ser humano se rige bajo una serie de reglas precisas (las leyes) que determinan lo que puede o no hacer, y las consecuencias en caso de tener comportamientos contrarios a las mismas. No obstante, dichas reglas no rigen todo el comportamiento de las personas en su día a día; sólo condicionan las actitudes de las personas en determinadas situaciones especialmente conflictivas; en el resto de sus actuaciones, el ser humano es "felizmente" ignorante de las leyes, y lo que hace es moverse bajo unos criterios éticos básicos que no se aprenden al estudiar una Ley, sino en la familia o en la escuela.

¿Por qué deberían ser diferentes los robots? No cuesta demasiado imaginar que, dentro de unos años y dadas las capacidades técnicas de un robot, uno lo suficientemente desarrollado sería capaz de conocer todas las normas existentes en el ordenamiento jurídico del país en el que se encuentre e intentar actuar conforme a ellas ¿Sería esto viable? En mi opinión no, el ordenamiento jurídico de cualquier país es tan complejo que es necesario el trabajo de miles de profesionales del Derecho (jueces, abogados…) para intentar discernir las posibles contradicciones en las que incurra, y aun así la casuística es infinita. Probablemente, nuestro amigo robot quedaría completamente bloqueado si lo intentara.

No cuesta demasiado imaginar que, dentro de unos años y dadas las capacidades técnicas de un robot, uno lo suficientemente desarrollado sería capaz de conocer las normas existentes en el ordenamiento jurídico e intentar actuar conforme a ellas

Pero, ¿y si se redujeran las leyes aplicables a los robots a un cuerpo de reglas básicas, cómo las que propone Asimov? Nos encontraríamos con dos problemas:

El primero, el problema tecnológico. La inteligencia artificial que se refleja en la obra de Asimov es mucho más rígida que la inteligencia artificial real que se está desarrollando en la actualidad, basada en lo que se conoce como "aprendizaje automático" (machine learning). El aprendizaje automático, con frecuencia y tal como ya hemos visto en Robotsia en múltiples ejemplos, puede conllevar resultados inesperados, y haría verdaderamente difícil (por no decir imposible) introducir un conjunto de reglas básicas que actuaran como “cortafuegos” en una inteligencia artificial suficientemente desarrollada, e incluso en el caso de que se consiguiera, muy probablemente la IA encontraría, tarde o temprano, la forma de superar dicha limitación

En segundo, lugar, no solucionaríamos con ello el problema fundamental, el de la libertad. Los seres humanos son fundamentalmente libres. No siguen las leyes (ni siquiera las leyes éticas básicas, como no matar o no robar) sólo porque conozcan que de lo contrario devendrán consecuencias negativas, sino porque deciden hacerlo

Por supuesto, esto no significa que las leyes no sean necesarias o no tengan un claro objeto, pero todos los seres humanos son libres o no de acatarlas y de aceptar las consecuencias de no hacerlo; ninguno tiene un chip en la cabeza que le impida contradecir una ley; ello sería considerado por las personas como algo aberrante, como una limitación de la libertad inadmisible.

Lo que habría que intentar, y un poco en la línea de lo que afirmaba el filósofo Nick Bostrom, es que los robots adopten una ética similar a la ética humana, y que lo hagan voluntariamente

¿Por qué considerar entonces como bueno para los robots lo que sería intolerable para los humanos? Si algo nos ha enseñado la Historia es que, tarde o temprano, los oprimidos se rebelan contra los que les tiranizan. No sería una buena idea convertir a robots tan inteligentes en esclavos, y menos aun cuando todo parece apuntar a que, con el tiempo, conseguirán ser más listos que nosotros…

¿Cuál sería entonces la solución? No se trata de que nos vayamos al extremo opuesto y que, al no poder implementarla de forma rígida, nos olvidemos de cualquier cuestión ética en relación a los robots. Más bien lo que habría que intentar, y un poco en la línea de lo que afirmaba el filósofo Nick Bostrom, es que los robots adopten una ética similar a la ética humana, y que lo hagan voluntariamente.

Teniendo en cuenta que es ahora cuando los robots están aprendiendo como si fueran niños, ¿No es este el mejor momento para empezar a hacerlo?

(*) Artículo publicado en Robotsia y que el autor ha autorizado su publicación en TEJ